Trends und Technologien

Datenschutz in der Softwareentwicklung mit KI berücksichtigen

22. Januar 2026 / Iris-Marina Nixdorf

Spätestens seit dem Inkrafttreten der DSGVO ist klar: Datenschutz ist ein zentrales Thema und muss von Unternehmen konsequent eingehalten werden. Beim Einsatz von Künstlicher Intelligenz kommen weitere Anforderungen hinzu – insbesondere durch die EU-KI-Verordnung sowie weitere bereits geltende Gesetze.

Bei der HEC unterstützt Bärbel Rolfes dabei, dass all diese Vorgaben eingehalten werden. Sie ist unter anderem GDD-geprüfte KI-Datenschutz-Expertin. Durch ihren Hintergrund in der Softwareentwicklung bringt sie das nötige technische Verständnis mit. Ihr Ziel ist es, der HEC und unseren Kunden einen transparenten, vertrauensvollen und rechtskonformen Einsatz von KI zu ermöglichen – im Einklang mit DSGVO und KI-VO. So lassen sich nicht nur rechtliche Risiken wie Bußgelder oder Schadensersatzansprüche vermeiden, sondern auch das Vertrauen in KI-Lösungen nachhaltig stärken.

Wie läuft in der HEC die Zusammenarbeit zwischen Datenschutz und Softwareentwicklung ab?

Bärbel: Die Sensibilisierung für das Thema und die nötige Wissensvermittlung sind ganz wichtiger Bestandteil der Zusammenarbeit. Alle an der Entwicklung Beteiligten nehmen bei uns verpflichtend alle zwei Jahre an individuell zugeschnittenen Datenschutz-Schulungen teil. Dabei geht es unter anderem um die Frage, wie und in welchem Umfang Privacy by Design und Privacy by Default in der Entwicklung umgesetzt werden können.

Ganz praktisch bedeutet das zum Beispiel: Entwicklungs-, Test- und Produktionssysteme müssen, besonders was personenbezogene Daten angeht, strikt getrennt sein. Anfragen von Betroffenen müssen im System berücksichtigt werden können. So müssen beispielsweise Daten vollständig löschbar sein.

In der Praxis gibt es in jedem unserer Projektteams ein Mitglied, das für den Datenschutz verantwortlich ist und die datenschutzkonforme Umsetzung im Blick behält. Bei Fragen oder Unsicherheiten werde ich frühzeitig eingebunden.

Ist Datenschutz schon bei der Anforderungserfassung neuer IT-Projekte ein Thema – auch wenn noch gar nicht klar ist, ob KI eingesetzt wird?

Bärbel: Ja, unbedingt. Datenschutz ist von Beginn an relevant. In der DoPi (Definition of Product Initiation) der HEC ist die Prüfung der Datenschutzanforderungen fest verankert. Bereits die fachlichen Anforderungen werden daraufhin überprüft, ob sie datenschutzkonform umsetzbar sind.

In Kundenprojekten liegt die Verantwortung für den Datenschutz grundsätzlich beim Kunden. Da viele Datenschutzbeauftragte juristisch geprägt sind und weniger technisches Know-how haben, unterstützen wir hier beratend. Wir erklären die technischen Hintergründe der Datenverarbeitung, zeigen Datenflüsse auf und beantworten konkrete technische Fragen.

Wäre es nicht einfacher, wenn du direkt die Datenschutzbeauftragte des Kunden wärst?

Bärbel: Genau deshalb habe ich diese Rolle für einige Kunden auch vertraglich übernommen. Als externe Datenschutzbeauftragte stehe ich im direkten Austausch mit den Kunden und informiere sie aktiv über rechtliche Neuerungen. Das mache ich sehr gerne, aber als Datenschutzbeauftragte bin ich immer nur beratend tätig. Der Datenschutz bleibt grundsätzlich in der Verantwortung des Kunden.

Welche Rolle spielt IT-Security beim Datenschutz?

Bärbel: Datenschutz und IT-Security arbeiten eng zusammen. IT-Security sorgt für die technischen und organisatorischen Maßnahmen, wie Datenverschlüsselung, Firewalls, regelmäßige Updates und Backups. Ohne eine solide IT-Security ist wirksamer Datenschutz nicht möglich.

Worauf kommt es beim Einsatz von KI besonders an?

Bärbel: Nehmen wir als Beispiel ein KI-gestütztes Adressverwaltungsprogramm. Erstens muss geprüft werden, welche Daten verarbeitet werden und auf welcher rechtlichen Grundlage das geschieht. Zentrale Datenschutzgrundsätze wie Datenminimierung, Zweckbindung, Rechtmäßigkeit und Speicherbegrenzung müssen eingehalten werden.

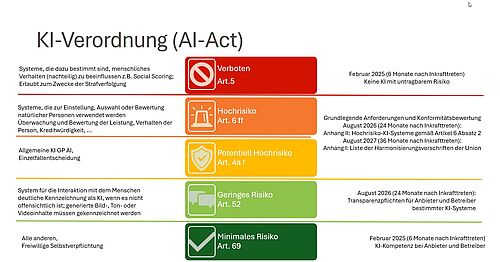

Zweitens wird bewertet, welcher Risikostufe das KI-System zuzuordnen ist. Ein hohes Risiko besteht zum Beispiel bei KI-Systemen für Social Scoring, also Bewertungen, die sich negativ auf Personen auswirken können. Hochrisiko-KI-Systeme unterliegen seit der KI Verordnung besonders strengen Anforderungen, etwa erweiterten Transparenz- und Dokumentationspflichten bis hin zu behördlichen Kontrollen. Und drittens wird abhängig von der Risikoeinstufung eine Datenschutzfolgenabschätzung (DSFA) durchgeführt, um mögliche Risiken zu identifizieren und zu minimieren. Bei uns betrifft das nur wenige Projekte.

Wie sieht das bei euren Anwendungen in der HEC aus?

Bärbel: Wir haben sowohl unser Projekt-Buchungssystem als auch unsere Microsoft-365-Anwendungen einer Datenschutzfolgenabschätzung unterzogen. Dabei wurde unter anderem geprüft, ob und in welchem Ausmaß Mitarbeitende geschädigt werden könnten.

Das Ergebnis ist jeweils eine Risikoeinschätzung inklusive geeigneter Gegenmaßnahmen – zum Beispiel die Anonymisierung von Daten, bevor eine KI damit arbeitet. In manchen Fällen bedeutet das auch, dass eine KI anders eingesetzt wird oder dass wir uns bewusst gegen eine KI-Lösung entscheiden.

Was sind risikobehaftete KI-Anwendungen – und können Kunden diese Einschätzung selbst vornehmen?

Bärbel: Welche KI-Anwendungen als risikobehaftet gelten, ist in der KI-Verordnung definiert. Die Einschätzung ist allerdings unterschiedlich komplex. Ein zentrales Kriterium ist, ob KI-Entscheidungen rechtliche Wirkungen entfalten oder Nachteile für Menschen entstehen können. Deshalb dürfen (Stand Januar 2026) KI-Entscheidungen niemals vollständig automatisiert erfolgen. Es muss immer eine menschliche Instanz geben, die die Entscheidung überprüft (Art. 22 DSGVO).

Besonders anspruchsvoll wird die Risikobetrachtung beim Einsatz von KI-Agenten. Diese können eigenständig Informationen recherchieren, mehrschrittig arbeiten, Software entwickeln oder komplette Strategien erstellen. Ein Beispiel wäre die vollautomatische Planung und Buchung einer Reise inklusive Flug und Hotel. In solchen Fällen sind Kontrollmechanismen und die Möglichkeit, Entscheidungen rückgängig zu machen, extrem wichtig.

Wer haftet eigentlich für KI-Ergebnisse?

Bärbel: Das KI-Recht ist Produktrecht, kein Softwarerecht. Während im klassischen Softwarerecht der Hersteller haftet, wenn eine Software fehlerhaft arbeitet, wird beim Produktrecht das Produkt losgelöst vom Hersteller betrachtet.

Ein Beispiel: ChatGPT ist für die Erstellung allgemeiner Texte gedacht. Wenn ein Nutzer durch seine Prompts illegale Inhalte erzeugt, haftet nicht der Hersteller, sondern der Anwender. Das ist notwendig, weil KI autonom und nicht vollständig vorhersehbar arbeitet. Ähnlich wie bei einer Axt: Der Hersteller haftet nicht dafür, wofür ich sie einsetze, ob für Baum oder Bein.

Was bedeutet das konkret für die Praxis?

Bärbel: Anbieter von KI-gestützter Software müssen umfassende Transparenzpflichten erfüllen. Betroffene müssen nachvollziehen können, wie ihre Daten verarbeitet werden und wie KI-gestützte Entscheidungen zustande kommen.

Dazu gehört auch, offenzulegen, mit welchen Daten die KI trainiert wurde, welches Ziel sie verfolgt und wie sie grundsätzlich arbeitet. Außerdem müssen Unternehmen regelmäßig prüfen, ob ihre Dienstleister gesetzliche Vorgaben bei Entwicklung und Betrieb von KI einhalten.

Datenschutz: Was ist organisatorisch und technisch zu tun?

Unternehmen sollten laut Bärbel Rolfes insbesondere folgende Punkte beachten:

- Regelmäßige Schulungen der Mitarbeitenden zu rechtlichen Aspekten von KI sowie Sensibilisierung für Datenschutz, KI-Ethik und Governance

- Nachweisbare KI-Kompetenz, dokumentierte Prozesse und klare Zuständigkeiten (verpflichtend laut KI-VO ab Februar 2025)

- Konsequente Einhaltung von Datenminimierung, Zweckbindung, Rechtmäßigkeit und Speicherbegrenzung

- Verschlüsselte Datenübertragungen innerhalb von KI-Infrastrukturen sowie Integritätsprüfungen

- Berücksichtigung von Betroffenenrechten (z. B. Löschung, Datenübertragbarkeit) auch bei trainierten Modellen

Diese Maßnahmen sind essenziell, um KI-Datenschutzrisiken proaktiv zu steuern und regulatorische Anforderungen zuverlässig zu erfüllen.

Was müsst ihr in Kundenprojekten mit KI beachten?

Bärbel: Hier müssen wir besonders auf Datenminimierung und Zweckbindung achten. Die Daten werden ja von den Kunden bereitgestellt und oft handelt es sich um sehr persönliche und vertrauliche Informationen, wie beispielsweise in Anwendungen, in denen KI relevante Daten aus E-Mail-Verkehren mit Geschäftspartnern generieren und verarbeiten soll.

Als Dienstleister dürfen wir immer nur die Daten verarbeiten, die für das KI-Modell zwingend erforderlich sind. Ich nenne mal zwei Beispiele: Für ein Programm zur Optimierung von Schiffsabfertigungen haben wir die Daten von Schiffsbewegungen verarbeitet, was keine sensiblen Daten sind. Bei der Zuordnung von individuellen Fähigkeiten der betreffenden Mitarbeitenden haben wir dem Kunden von der Verwendung der personenbezogenen Daten abgeraten. Zweites Beispiel: Eine nicht zulässige Anwendung ist die Verarbeitung von Zeiterfassungsdaten mit allen Abwesenheits- und Krankheitsdaten, um Vorhersagen über die Einsetzbarkeit der Mitarbeitenden zu treffen.

Die Zweckbindung der Datenerfassung spielt hier eine wichtige Rolle: Der Zweck muss klar dokumentiert und kommuniziert werden. Eine Weiterverwendung ist nur nach erneuter Prüfung zulässig. Daraus ergibt sich auch, wer Zugriff auf welche Daten benötigt. Hier gilt konsequent das Need-to-know-Prinzip. Darüber hinaus muss grundsätzlich der Einsatz von KI verhältnismäßig, nachvollziehbar und erklärbar sein (Explainability). Dieses Thema besprechen wir frühzeitig mit den Entwicklungsteams.

Bei der Verarbeitung von sensiblen Daten ist zudem eine Datenschutzfolgenabschätzung verpflichtend. In Kundenprojekten empfehlen wir außerdem klare Vereinbarungen zur Auftragsverarbeitung und zur Nutzung sowie zur Kontrolle der Daten.

Wie gehen Kunden mit Zugriffsrechten um?

Bärbel: Das ist sehr unterschiedlich. Unternehmen aus dem medizinischen Umfeld oder Betreiber von Webshops mit Kundendaten sind meist sehr sensibel. Andere, deren Daten weniger geschäftskritisch sind, gehen oft sorgloser damit um. Unsere Empfehlung ist klar: Zuerst immer über die Zweckbindung der Daten nachdenken. Häufig schließen sich dadurch bestimmte Daten – und damit auch bestimmte KI-Einsätze – von selbst aus.

Wenn Sie Fragen zum Thema haben, dann sprechen Sie mich an

Bärbel Rolfes

Beratung Datenschutz0421 20750 371 E-Mail senden

Expertin für Datenschutz und Anforderungsmanagement

Bärbel ist als Datenschutzbeauftragte und Anforderungsmanagerin bei der HEC im Einsatz.

Ihrem Motto „Wissen ist wertvoll – aber erst durch neues Lernen wird es lebendig“ wird sie hier gerecht: Denn sie verbindet ihr fachliches Know-how mit rechtlicher Expertise, für die sie sich fortlaufend mit den neuesten Methoden zum Anforderungsmanagement und Gesetzgebungen auseinandersetzt.

Sie kann Bedürfnisse der Nutzer mit den technischen und rechtlichen Rahmenbedingungen in Einklang bringen und gemeinsam mit unseren Kunden Lösungen entwickeln, die so rechtssicher wie praxistauglich sind.